您当前的位置:主页 > 教程合集 > SEO入门到精通 > 网站首页SEO入门到精通

SEO入门到精通(三):搜索引擎介绍(工作原理)

发布时间:2019-10-22来源:马兔子作者:马兔子阅读:(0)字号: 大 中 小

做SEO就不要搜索引擎和浏览器傻傻分不清楚了,这样可是会闹笑话的。

一、浏览器和搜索引擎的区别

1、浏览器常见的有:搜狗浏览器、360浏览器、谷歌浏览器、QQ浏览器等等,浏览器是指可以显示网页服务器或者文件系统的HTML文件(标准通用标记语言的一个应用)内容,并让用户与这些文件交互的一种软件。手机浏览器和电脑浏览器功能类似。

简单说,浏览器是一种软件,主要的功能是翻译网页代码,将原始网页代码翻译成你看到的形形色色的页面。

2、常见的搜索引擎有:Google、百度、搜索、360、bing等。国内无法使用Google,但是全球90%的国家都在使用Google,百度是最大的中文搜索引擎,Google是全球最大的搜索引擎。

二、搜索引擎工作原理

每个SEO从业人员,都必须要理解搜索引擎的工作原理,明白搜索引擎怎么去工作的,才能做好搜索引擎优化工作。

首先,要明白搜索引擎的工作过程是非常复杂的,但是可以简化为三个阶段:

(1)网页收集。通过蜘蛛(即网络爬虫)去爬取网页,并抓取回来,作为原始数据存储起来。

(2)预处理。抓取回来的页面不能直接被用户搜索到,需要经过处理排序,才能参与排名。

(3)检索服务。用户输入查询内容后,搜索引擎的排名程序调用索引库中的数据,将用户搜索内容进行匹配后展现给用户。接下来,我们来深入理解这三个步骤。

1、网页收集

搜索引擎通过蜘蛛爬取并收集互联网上的网页,网页的收集是搜索引擎工作的第一步,了解搜索引的抓取机制,便于蜘蛛抓取更多的页面,有利于网站的排名。

(1)蜘蛛是什么

网络爬虫,又被称为网页蜘蛛、网络机器人,是按照一定的规则,自动抓取互联网中网页的程序或者脚本。由于互联网被比喻为一张大网,那么在这张大网上爬取的程序,就自然被叫做蜘蛛了。

(2)蜘蛛工作方式

为了更高效的爬取互联网上的页面,蜘蛛需要制定爬取策略,简单来说,爬取策略分为两种:深度优先和广度优先。

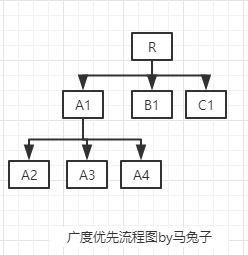

广度优先:蜘蛛会优先抓取起始页面中的全部链接,再选择其中的一条网页链接,继续抓取这个页面上的所有链接,这种方式可以让蜘蛛并行抓取,提高抓取速度。如图所示:蜘蛛从R页面顺着URL(链接)爬行到A1、B1、C1页面,当R页面链接抓取完后,再从A1爬取到A2、A3、A4页面,按照这种方式一直持续下去。

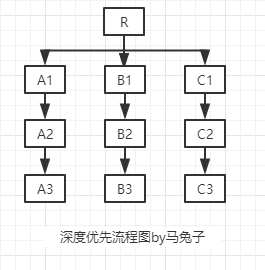

深度优先:蜘蛛会从原始页面开始抓取,发现一个链接,就会顺着这个链接一直抓取下去,直到无链接可抓,才会返回去,抓取另一条链接,并持续跟踪这条链接直到没有链接可以抓取。蜘蛛从R页面爬取到A1、A2、A3页面,到A3页面已经没有链接可以爬取了,就返回到R页面重复之前的操作。

在实际的爬取过程中,深度优先和广度优先往往都是混合使用的,这样既可以爬取更多的网站,又可以兼顾到更多的网站内页。不仅如此,在爬取页面的过程中,需要考虑的因素还有很多,比如:网页权重、网站的规模、网站外链数量、网站的更新频率等等,都会影响到页面的爬取。这也是在以后我们做网站优化是需要考虑的问题,可以思考:下如何布置网站才容易让蜘蛛爬取,进而提高网页收录。

(3)种子站点

一般来说,种子站点都是权重高、权威度高的网站,像网易、知乎、hao123等这类网站,要么是行业大站,要么是优质的导航站。蜘蛛爬行也往往以这些网站作为原始页面进行爬取。因此在优化网站的时候,可以在这类网站上多做一些外链,进而吸引蜘蛛来爬取我们的站点。

(4)搜索引擎的收集机制

这点对我们的网站收录影响很大,一定要注意。蜘蛛抓取某一网站的频次,主要受限于网站的表现情况,若网站更新有规律,蜘蛛就会规律的进入网站进行抓取。

蜘蛛每次爬行都会把页面数据存储起来,如果第二次爬取发现页面与第一次收录的完全一样,说明页面没有更新,多次抓取后蜘蛛会对网站更新频率有一定掌握。更新频率低的网站,蜘蛛抓取的频次就相对较少,更新频率高的网站,蜘蛛也会更频繁的到访抓取。因此优化网站时,需要定期定量更新内容,蜘蛛才会有规律抓取。

(5)文件存储

搜索引擎会将蜘蛛抓取回来的文件存储到原始数据库中,并进一步的处理。如何进行处理呢?咱们下节课就会讲到。

关键字词: